هوش مصنوعی مثل ChatGPT روزبهروز بیشتر وارد زندگی ما میشود، اما آیا به نظرتان میتوانیم به آن کاملا اعتماد کنیم؟ یک آزمایش ساده با خطای دید ChatGPT نشان داد که حتی مدلهای پیشرفته هم فریب میخورند. این موضوع به ما یادآوری میکند که هوش مصنوعی هنوز با درک انسانی فاصله دارد و نباید بدون بررسی به نتایج آن تکیه کنیم.

جدیدترین اخبار تکنولوژی هوش مصنوعی و شبکههای اجتماعی را در نامبرلند بخوانید.

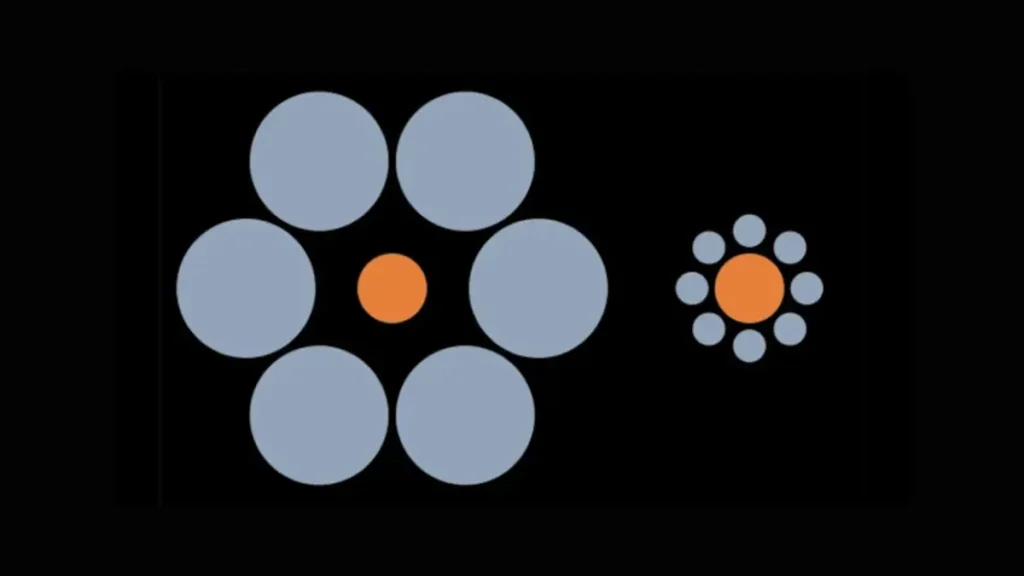

براساس گزارش TechRadar، نویسنده با استفاده از یک تصویر مشهور به نام Ebbinghaus Illusion (خطای دید ابینگهاوس) توانست ChatGPT را گمراه کند. در این آزمایش، ChatGPT با اطمینان اعلام کرد که دو دایرهی نارنجی هماندازهاند، در حالی که تصویر دستکاری شده بود. این یعنی مدل بیشتر به شباهتهای آماری اینترنت تکیه کرده تا تحلیل واقعی تصویر.

آسیبپذیری و خطاهای ChatGPT

این اتفاق اهمیت زیادی دارد، چون نشان میدهد ChatGPT و مدلهای مشابه هنوز در برابر خطاهای طراحیشده یا تصاویر ساختگی آسیبپذیرند. کارشناسان یادآور میشوند که مدلهای زبانی اساساً پیشبینیگر هستند، نه تحلیلگر بصری.

برای کاربران عادی، این تجربه یک هشدار جدی است: هوش مصنوعی میتواند ابزار قدرتمندی برای نوشتن متن، یادگیری یا تولید محتوا باشد، اما نتیجهی آن همیشه قطعی و درست نیست.

در نهایت، ما در ابتدای راه هوش مصنوعی هستیم. چنین خطاهایی هرچند ترسناک بهنظر میرسند، اما میتوانند نقطهی شروعی برای پیشرفت و مقاومتر کردن مدلها باشند.

- برای درک بهتر تغییرات و محدودیتهای ChatGPT، میتوانید خبر تغییرات تیم توسعه شخصیت ChatGPT را هم بخوانید؛ گزارشی که توضیح میدهد چرا اوپناِیآی ساختار تیمهایش را دوباره سازماندهی کرده است.