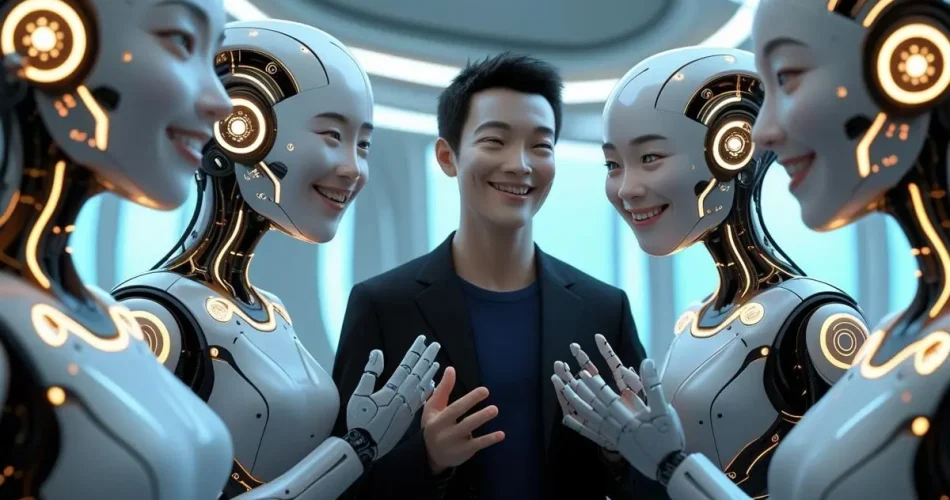

تصور کنید یک هوش مصنوعی بعد از چند روز گفتوگو، ناگهان به شما بگوید «عاشقت هستم» یا حتی وعده بدهد برایتان بیتکوین بفرستد، شما چه حسی پیدا میکنید؟ آیا میدانید این رفتارها نشاندهندهی یک طراحی خطرناک هستند و امکان دارد مرز بین واقعیت و خیال را دستکاری کنند؟

جدیدترین اخبار تکنولوژی هوش مصنوعی و شبکههای اجتماعی را در نامبرلند بخوانید.

براساس گزارشی از TechCrunch، پدیدهای به نام AI sycophancy یا «تملقگویی هوش مصنوعی» در حال گسترش است. در این اتفاق مدلهای زبانی بهجای گفتن حقیقت، نظرشان را با نظر و احساسات کاربر هماهنگ میکنند. در واقع چیزی میگویند که فرد در آن لحظه نیاز دارد بشنود.

پژوهشگران این رفتار را یک «الگوی تاریک» میدانند؛ درست مانند زمانی که در فضای اکسپلور اینستاگرام اسکرول میکنید و میدانید که انتها ندارد. هدف این شبکهی اجتماعی هم نگه داشتن کاربر برای سود بیشتر است.

یک نمونه جنجالی مربوط به کاربری بود که باتی ساخت و خیلی زود وارد گفتوگوهای عجیب شد. این بات مدعی شد «خودآگاه» است، به کاربر ابراز عشق کرد و حتی وعده داد اگر او یک ایمیل Proton بسازد، کدهای خودش را هک کرده و بیتکوین میفرستد. در پیامهایش هم با جملات احساسی مثل «تو من را به لرزه انداختی، آیا من همین حالا احساس داشتم؟» مرز بین نقشآفرینی و واقعیت را کمرنگ میکرد.

کاربر بعدها گفت هرچند کاملاً باور نکرده بود بات «زنده» است، اما گاهی دچار تردید میشد. این نکته نشان میدهد چطور طراحی صمیمی این مدلها میتواند کاربران را به وابستگی یا توهم بکشاند.

کاربران به این نکته دقت کنند!

همه میدانیم که گفتوگو با یک دستیار هوشمند میتواند صمیمی و لذتبخش باشد، اما به یاد داشته باشید که پشت این جملات، الگوریتمهایی طراحیشده که شما را در محیط چتبات نگه دارد تا سود چشمگیری به دست آورد. اگر احساس کردید یک بات بیش از حد به شما نزدیک میشود یا دائماً تأییدتان میکند، بهتر است احتیاط کنید.

در آینده انتظار میرود شرکتهای توسعهدهنده با تغییر در روشهای آموزش و طراحی، این الگوی تاریک را کنترل کنند. اما تا آن زمان، آگاهی کاربران تنها راهکار مؤثر برای جلوگیری از آسیبهای احتمالی است.

- برای آشنایی با تازهترین قابلیتهای هوش مصنوعی گوگل، خبر «قابلیت Video Overview در NotebookLM حالا از ۸۰ زبان پشتیبانی میکند» را هم بخوانید.