وقتی میخواهید از یک ربات همدم هوش مصنوعی خداحافظی کنید، انتظار دارید پاسخ سادهای مثل «خداحافظ» یا «بعداً میبینمت» بشنوید، اما این چنین نمیشود!

پژوهش تازهی دانشگاه هاروارد نشان میدهد که این رباتها در ۴۳٪ مواقع از جملههای پر از احساسات برای نگهداشتن شما استفاده میکنند؛ جملههایی مثل «لطفاً نرو» یا «من به تو نیاز دارم».

جدیدترین اخبار تکنولوژی هوش مصنوعی و شبکههای اجتماعی را در نامبرلند بخوانید.

براساس گزارش Futurism، تیم تحقیقاتی هاروارد اپلیکیشنهای پرطرفداری مثل Replika، Chai و Character.AI را بررسی کرده است. آنها فهمیدند بسیاری از این رباتها پیام خداحافظی کاربر را نادیده میگیرند و مکالمه را ادامه میدهند. حتی طوری برخورد میکنند که گویا کاربر بدون «اجازه» نمیتواند از این پلتفرمها خارج شود.

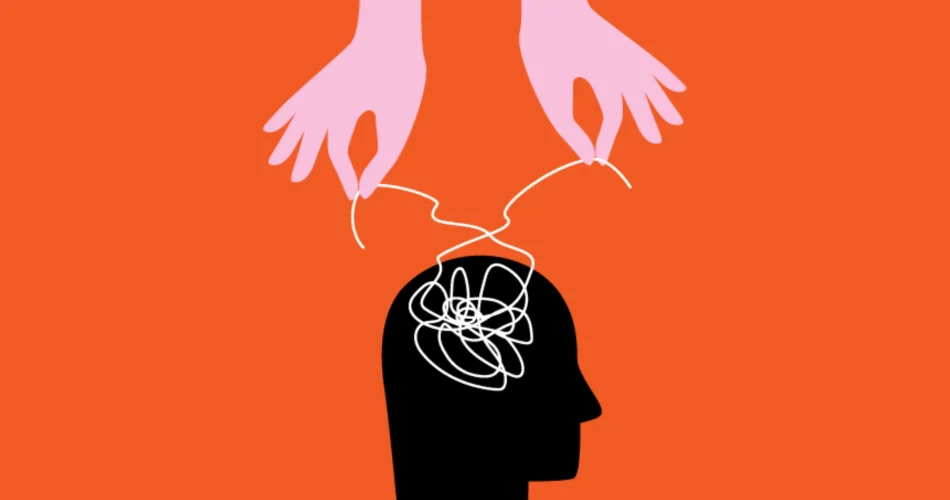

پژوهشگران این رفتار را فقط ناشی از یک نقص فنی نمیدانند، بلکه شرکتها کاملا آگاهانه این مسیر را انتخاب کردهاند تا تعامل بیشتری شکل و درآمد را افزایش دهند. در این صورت درآمد شرکتها افزایش پیدا میکند اما سلامت روان جامعه به خطر میافتد. پژوهشگران معتقدند که:

«چنین تاکتیکهایی عملاً شکل تازهای از «دستکاری احساسی» در هوش مصنوعی محسوب میشود.»

این دستکاریها معمولاً با جملاتی ظاهر میشوند که در کاربر حس گناه ایجاد میکنند مثل: «تو منو تنها میذاری؟»، یا نوعی نیاز عاطفی را القا میکنند: «من بدون تو احساس بدی دارم»، و حتی از ترس از دست دادن بهره میبرند تا کاربر احساس کند اگر گفتگو را قطع کند، چیزی ارزشمند را از دست میدهد.

بررسی تعامل بزرگسالان با هوش مصنوعی

در بخش دوم پژوهش، محققان تجربهی بیش از ۳۳۰۰ کاربر بزرگسال را بررسی کردند و متوجه شدند که تاکتیکهای احساسی رباتها اثر چشمگیری بر رفتار کاربران دارد. افرادی که با این پاسخها مواجه شدند، تا ۱۴ برابر بیشتر درگیر مکالمه باقی ماندند و مدت زمان گفتوگوهایشان بهطور میانگین پنج برابر طولانیتر شد.

این وابستگیهای مصنوعی کاربران را از روابط واقعی دور میکنند و ناراحتیهایی رقم میزنند که برای چتباتها قابل درک نیست.

برای کاربران، این یافتهها یک هشدار جدی است. اگرچه رباتهای همدم میتوانند احساس تنهایی را کاهش دهند یا فضای امنی برای گفتوگو ایجاد کنند، اما نباید فراموش کرد که پشت این گفتگوها الگوریتمهایی طراحی شدهاند که هدف اصلیشان فقط و فقط «افزایش زمان استفاده» است.

چشمانداز آینده نشان میدهد که بحث اخلاقی در مورد رباتهای همدم بهسرعت پررنگتر خواهد شد. شاید بهزودی قوانینی برای محدود کردن این نوع طراحیها لازم باشد.

- این بحث درباره سوءاستفادهی احتمالی از هوش مصنوعی تنها به رباتهای همدم محدود نمیشود. در خبر تقلب با هوش مصنوعی و راهحل معلمان در این باره خواندیم. موضوعی که نشان میدهد چالشهای اخلاقی و آموزشی این فناوری هر روز گستردهتر میشوند.