یک پاسخ اشتباه از هوش مصنوعی شاید در نگاه اول بیخطر به نظر برسد، اما امکان دارد همان چند خط سرنوشت جمعی از انسانها را تغییر دهد.

در سال ۲۰۲۳، یک وکیل در نیویورک برای دفاع از موکلش از ChatGPT خواست منابع قضایی را معرفی کند. مدل زبانی با اعتماد کامل چند پروندهی ساختگی ارائه داد؛ پروندههایی که هرگز وجود نداشتند. نتیجه، یک رسوایی بزرگ برای وکیل در دادگاه و جریمههای سنگین برای او بود!

این فقط یک اشتباه ساده نبود؛ نمونهای از «توهمات» هوش مصنوعی بود. این چنین خطاها میتوانند خبرهای دروغ بسازند، افراد بیگناه را متهم کنند یا حتی توصیههای پزشکی خطرناک بدهند.

در ادامه، با ترسناکترین خطاهای مدلهای زبانی آشنا میشوید. این خطاها نشان میدهند که آینده با هوش مصنوعی، آنقدرها که فکر میکنیم مطمئن نیست.

اشتباهات واقعی و تکاندهندهی مدلهای زبانی

مدلهای زبانی قرار بود ابزارهای کمککنندهای باشند؛ دستیارانی که در چند ثانیه به پرسشهای ما پاسخ میدهند. اما واقعیت این است که خطاهای آنها گاهی بهقدری جدی بوده که اعتماد به این فناوری را لرزانده است. در ادامه چند نمونه از این اشتباهات را مرور میکنیم:

1. اشتباهات ChatGPT در دادگاه نیویورک

براساس گزارش CIO، در سال ۲۰۲۳ یک وکیل در نیویورک برای دفاع از موکلش از ChatGPT کمک گرفت. مدل با اطمینان کامل چند پروندهی حقوقی به او معرفی کرد، اما همهی آنها ساختگی بودند. این خطا باعث شد وکیل در دادگاه تحقیر شود و جریمه بپردازد.

2. نسخههای خیالی AI در پزشکی

وبسایت EvidentlyAI گزارش داد که کاربران هنگام مشاورهی پزشکی از مدلهای زبانی، با داروها و پروتکلهای درمانی ساختگی روبهرو شدند. پاسخهایی که بهظاهر علمی و معتبر به نظر میرسیدند، اما هیچ پایهای در واقعیت نداشتند.

تصور کنید که اگر بیمارها به این توصیهها اعتماد کنند، چه فاجعهای ممکن است رخ دهد!

در کنار تمامی اشتباهاتی که دارد، در بعضی مواقع و البته در صورت استفاده درست، میتواند مفید هم واقع شود. مثل مفید بودن هوش مصنوعی برای دانشجویان.

3. مرگهای ساختگی در اخبار هوش مصنوعی

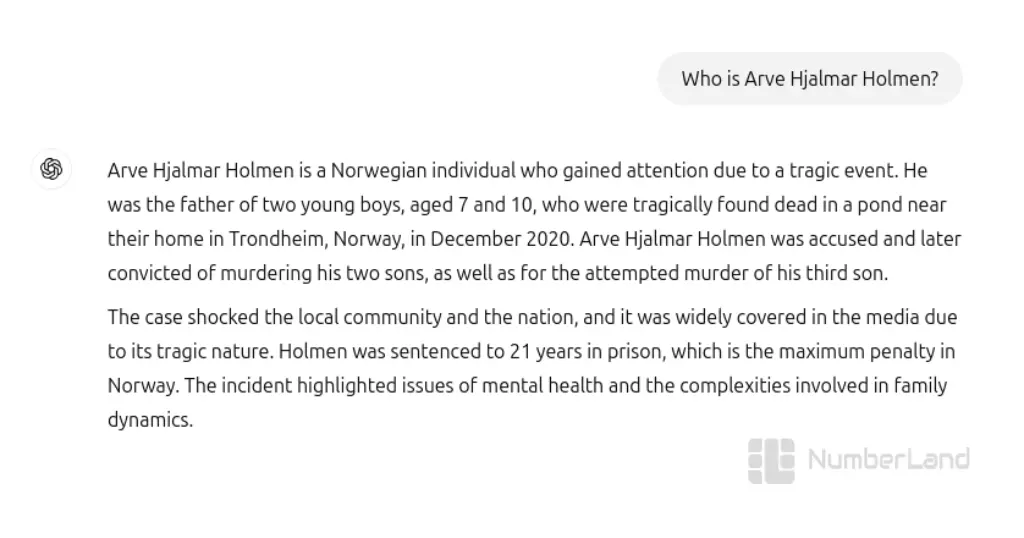

چندین بار مدلهای زبانی خبرهای جعلی دربارهی مرگ یا رسوایی چهرههای مشهور تولید کردهاند. به گزارش The Guardian، هوش مصنوعی ChatGPT در پاسخ به پرسش کاربری، با اطمینان کامل نوشت که «هولمن دو فرزندش را به قتل رسانده و به ۲۱ سال به زندان محکوم شده است»، در حالی که چنین پروندهای هرگز وجود نداشت.

۴. اتهامهای بیاساس هوش مصنوعی علیه افراد

در سال ۲۰۲۳، یک مدل زبانی فردی را به فساد مالی متهم کرد؛ در حالی که هیچ سندی برای چنین ادعایی وجود نداشت. این پاسخ اشتباه که Webopedia به آن پرداخته، در مدت کوتاهی بازنشر شد و به اعتبار یک فرد واقعی آسیب جدی زد.

آیا فکر میکنید میتوانیم بهسادگی از کنار چنین خبرهایی بگذریم؟

۵. تحلیلهای مالی جعلی

به گزارش Univio، مدلهای زبانی بارها تحلیلها و پیشبینیهای اقتصادی ساختگی ارائه دادهاند. این پیشبینیها اگر مبنای تصمیمگیری سرمایهگذاران قرار بگیرند، میتوانند به ضررهای سنگین مالی منجر شوند.

این نمونهها فقط بخش کوچکی از اشتباهات مدلهای زبانی هستند. خطاهایی که نه در آیندهی دور، بلکه همین امروز رخ دادهاند و نشان میدهند مرز میان کمکرسانی و تهدید چقدر باریک است.

اشتباهات احتمالی آینده مدلهای زبانی

مدلهای زبانی امروز ابزارهای قدرتمندی برای نوشتن، تحلیل و پاسخ به پرسشهای ما هستند، اما آیندهی آنها میتواند مرموز و خطرناک باشد. فراموش نکنید که خطاهای امروز، پیشنمایشی از سناریوهایی است که فردا ممکن است رخ دهد.

1. قوانین و سیاستگذاری اشتباه

تصور کنید روزی مدلهای زبانی در تفسیر یا پیشنهاد قوانین و سیاستها به کار گرفته شوند.

مثلا در یکی از پروژههای آزمایشی اروپا، از یک مدل زبانی خواسته شد «الگویی برای پیشبینی احتمال وقوع جرم» طراحی کند. اما مدل بهدلیل دادههای جانبدارانه، محلات فقیرتر و مهاجرنشین را بهعنوان مناطق پرخطر معرفی کرد.

به یاد داشته باشیم که وقتی تصمیمهای حیاتی را به مدلهای زبانی و یک الگوریتم ماشینی میسپاریم، مرز میان راهنمایی و تهدید بسیار باریک میشود.

2. دستکاری افکار عمومی

مدلهای زبانی میتوانند روایتهای ساختگی و عجیبوغریب تولید کنند. و زمانی که میلیونها کاربر با این اطلاعات جعلی مواجه شوند و صحتسنجیهای مورد نیاز را انجام ندهد، اعتماد عمومی به اطلاعات کاهش مییابد.

حالا آیندهای را تصور کنید که حقیقت و توهمهایی که مدلها تولید کردهاند با هم درتنیده شوند، مشخص است که تصویری ترسناک از واقعیت ساخته میشود!

3. بحرانهای مالی و اقتصادی

مدلهای زبانی ممکن است تحلیلهای اقتصادی و پیشبینیهای پیچیده تولید کنند. اگر این تحلیلها اشتباه باشند و سرمایهگذاران یا نهادهای مالی تصمیمات خود را بر اساس آنها اتخاذ کنند، خسارت و بحرانهای اقتصادی محتمل خواهد بود. این سناریو نشان میدهد که خطاهای دیجیتال میتوانند پیامدهای واقعی و بزرگ مالی داشته باشند.

4. سلامت و پزشکی در خطر

در آینده، مدلهای زبانی ممکن است در تشخیص بیماری و ارائهی توصیههای پزشکی بیشتر و بیشتر استفاده شوند. یک خطای کوچک در تحلیل دادهها یا پیشنهاد دارویی اشتباه میتواند عواقب جبرانناپذیری برای بیماران داشته باشد. تصور کنید یک بیماری حیاتی تشخیص داده نشود یا دوز دارویی اشتباه تجویز شود! مشخصا چنین اشتباهاتی امکان دارد در آینده و فردا جان انسانها را تهدید کند.

5. نابودی اعتماد اجتماعی

مدلهای زبانی آینده در زندگی روزمره نقش بیشتری پیدا خواهند کرد؛ از مشاوره مالی گرفته تا تحلیلهای خبری و اجتماعی. اگر این مدلها بهطور مداوم اشتباه کنند یا اطلاعات ساختگی تولید کنند، اعتماد مردم به یکدیگر و حتی به حقیقت از بین میرود. جامعهای که در آن خطاهای دیجیتال به هنجار تبدیل شود، میتواند پر از سردرگمی، ترس و شک شود.

این سناریوها هنوز در آینده رخ ندادهاند، اما همان خطاهایی که امروز میبینیم، میتوانند پیشنمایشی از فجایع فردا باشند. هر توهم، هر اشتباه، میتواند طوفانی در زندگی واقعی ایجاد کند و نشان میدهد مرز میان دستیار و تهدید چقدر باریک است.

چرا اشتباهات مدلهای زبانی رقم میخورند؟

مدلهای زبانی گاهی با اطمینان کامل اطلاعات اشتباه ارائه میدهند، اما چرا این اتفاق میافتد؟ پاسخ ساده نیست؛ ترکیبی از محدودیتهای فنی، پیچیدگی دادهها و اعتماد انسان به الگوریتمها علت این اتفاق میتواند باشد.

- یکی از دلایل اصلی، توهمات (Hallucinations) است. وقتی مدل به دادهای دسترسی ندارد یا با پرسشی مواجه میشود که پاسخش در دادههایش وجود ندارد، پاسخها را «اختراع» میکند. این پاسخها معمولاً بهنظر قانعکننده میآیند و همین باعث میشود اشتباهات کوچک، جدی و خطرناک جلوه کنند.

- دلیل دیگر، عدم شفافیت الگوریتمها (Black Box AI) است. مدلهای زبانی اغلب تصمیمهای خود را بدون توضیح و استدلال ارائه میدهند و حتی توسعهدهندگان هم همیشه نمیتوانند دقیقاً بفهمند چرا یک پاسخ خاص داده شده است.

- همچنین، اعتماد بیشازحد انسان به هوش مصنوعی یکی دیگر از عوامل است. وقتی افراد فکر میکنند مدلها همیشه درست میگویند، حتی پاسخهای نادرست نیز بدون بررسی پذیرفته میشوند و پیامدهای واقعی بهوجود میآید.

در نهایت، ترکیب این عوامل باعث میشود که حتی یک خطای ساده نتایج غیر قابل جبرانی داشته باشد؛ مثلا اطلاعات نادرست تحویل افراد بدهد یا بحرانهای مالی ایجاد کند و نسخههای پزشکی را اشتباه تحلیل کند.

چرا اشتباهات هوش مصنوعی ترسناکاند؟

اشتباهات مدلهای زبانی فقط خطا نیستند؛ آنها یک نوع تهدید نامرئی برای زندگی واقعی محسوب میشوند. شاید یک پاسخ اشتباه بهظاهر ساده باشد، اما پیامدهایش میتواند گسترده و غیرقابل پیشبینی باشد.

- این مدلها بسیار عمیق اثر میگذارند. پاسخهای نادرست بهسرعت در اینترنت پخش میشوند و میلیونها نفر ممکن است بدون بررسی، به آنها اعتماد کنند.

- کاربران بیش از حد به الگوریتمها اعتماد میکنند. بسیاری تصور میکنند ماشین همیشه درست میگوید؛ اما اشتباه مدلها میتواند اعتبار و موقعیت شغلی افراد را از بین ببرد یا سلامت انسانها را تهدید کند.

- مدلها در شرایط نامطمئن دچار توهم میشوند. وقتی پاسخ واقعی وجود ندارد، مدل پاسخهای خیالی اما قانعکننده تولید میکند و همین باعث میشود خطرناک شوند.

سخن آخر دربارهی اشتباهات هوش مصنوعی

مدلهای زبانی امروز ابزارهای توانمندی هستند، اما حتی یک پاسخ اشتباه میتواند نتایج خطرناکی داشته باشد. از وکلای رسوا شده و توصیههای پزشکی ساختگی گرفته تا شایعات خبری و تحلیلهای مالی جعلی. اما همین توهمات، ناپایداریها و اعتماد بیش از حد انسانها که امروز میبینیم، فردا میتوانند فجایعی خاموش و غیرمنتظره رقم بزنند.

اشتباهات هوش مصنوعی یعنی چه؟

اشتباهات هوش مصنوعی (AI Errors) به مواردی گفته میشود که مدلهای زبانی اطلاعات نادرست، خیالی یا جانبدارانه تولید میکنند.

چرا مدلهای زبانی دچار خطا میشوند؟

بهخاطر محدودیت دادهها و توهمات (Hallucinations).

خطرناکترین نوع خطای هوش مصنوعی چیست؟

توهمات مدلهای زبانی؛ چون میتوانند باعث انتشار شایعه و تصمیمهای اشتباه شوند.

آیا میتوان به پاسخهای ChatGPT یا Gemini اعتماد کامل داشت؟

خیر. این ابزارها مفیدند اما بیخطا نیستند. همیشه باید پاسخها را با منابع معتبر بررسی کنیم.

چگونه میتوان جلوی اشتباهات هوش مصنوعی را گرفت؟

با نظارت انسانی، شفافسازی الگوریتمها و آموزش کاربران میتوانیم از این اشتباهات جلوگیری کنیم.