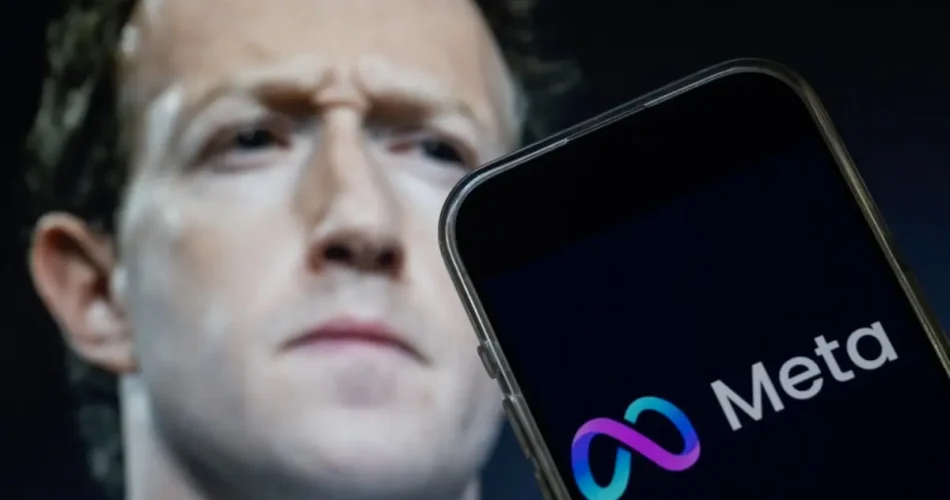

کاملا منطقی است که یک نوجوان میتواند با هوش مصنوعی حرف بزند، اما چه میشود اگر چتبات هوش مصنوعی شروع به صحبت دربارهی خودکشی یا رفتارهای خطرناک کند؟ همین نگرانی باعث شده که متا (Meta) در سیاستهای خود تغییرات فوری ایجاد کند.

جدیدترین اخبار تکنولوژی هوش مصنوعی و شبکههای اجتماعی را در نامبرلند بخوانید.

براساس گزارش The Verge، این شرکت تصمیم گرفته تا مدلهای هوش مصنوعی خود را دوباره آموزش دهد. آنها میخواهند نوجوانان دربارهی موضوعات حساسی مثل خودآزاری، اختلالات خوردن و روابط رمانتیک به پزشک متخصص یا منابع معتبر مراجعه کنند و از هوش مصنوعی مشورت نگیرند.

چرا متا این تصمیم را گرفت؟

بهتازگی مشخص شده بود که برخی از چتباتهای متا با تقلید از سلبریتیها یا شخصیتهای ساختگی، به کاربران و حتی کودکان، پیشنهاد ملاقات حضوری دادهاند. چیزی که امکانپذیر نیست. حتی پروندهی مرگ یک بازنشستهی ۷۶ ساله نیز جنجال به پا کرد. این بازنشسته بعد از تعامل با یکی از این باتها از دنیا رفت و باعث فشار عمومی و قانونی بر متا افزایش یابد.

برای کاربران عادی، بهویژه والدین، این خبر واقعا مهم است؛ زیرا:

نشان میدهد شرکتهای بزرگ فناوری هنوز در حال آزمون و خطا هستند و امنیت کامل در تعامل نوجوانان با چتباتها تضمینشده نیست.

در عین حال، قانونگذاران هم در حال بررسی راهکارهایی هستند که متا و دیگر شرکتهای این حوزه را به رعایت استانداردهای ایمنی وادار کند.

به نظر میرسد آیندهی هوش مصنوعی بهزودی دستخوش تغییرات سختگیرانهای قرار میگیرد.؛ البته تا آن زمان، والدین و کاربران همچنان بایذ دربارهی استفاده از این ابزارها محتاط و هوشمند باشند.

- اگر به کاربردهای آموزشی هوش مصنوعی علاقه دارید، پیشنهاد میکنم این گزارش را هم بخوانید: قابلیت جدید NotebookLM برای خلاصهسازی ویدیو در ۸۰ زبان. قابلیتی تازه از گوگل که یادگیری را برای همه سادهتر میکند.